Nowość – instancje EC2 obsługiwane przez akceleratory Gaudi do trenowania modeli uczenia głębokiego

W obecnych czasach istnieje o wiele więcej aplikacji służących do uczenia głębokiego (uczenia maszynowego) niż kiedykolwiek wcześniej. Przetwarzanie języka naturalnego, systemy rekomendacji, rozpoznawanie obrazu, wideo i nie tylko mogą korzystać z wysokiej jakości dobrze wyszkolonych modeli.

Proces budowania takiego modelu jest iteracyjny: skonstruuj początkowy model, wytrenuj go na danych dotyczących prawdy podstawowej, wykonaj kilka wniosków testowych, udoskonal model i powtórz. Modele uczenia głębokiego zawierają wiele warstw (stąd ich nazwa), z których każda przekształca dane wyjściowe poprzedniej warstwy. Proces uczenia wymaga zaawansowanej matematyki i procesora oraz stawia wymagania niemal każdej części systemów używanych do uczenia, w tym procesorowi graficznemu lub innym akceleratorom uczenia, sieci oraz pamięci lokalnej lub sieciowej. To wyrafinowanie i złożoność wydłuża czas szkolenia i podnosi koszty.

Nowe instancje DL1

Dzisiaj twórcy chcieliby opowiedzieć o swoich nowych instancjach DL1. Zasilane przez akceleratory Gaudi z Habana Labs, instancje dl1.24xlarge mają następujące specyfikacje:

- Akceleratory Gaudi – każda instancja jest wyposażona w osiem akceleratorów Gaudi, łącznie z 256 GB pamięci akceleratorów High Bandwidth (HBM2) i szybką komunikacją między akceleratorami za pomocą technologii RDMA.

- Pamięć systemowa – 768 GB pamięci systemowej, wystarczającej do przechowywania w pamięci bardzo dużych zestawów danych treningowych, o co często prosili klienci.

- Pamięć lokalna — 4 TB lokalnej pamięci NVMe, skonfigurowane jako cztery woluminy 1 TB.

- Procesor – procesor Intel Cascade Lake z 96 vCPU.

- Sieć – 400 Gbps przepustowości sieci.

Jak możesz zauważyć, twórcy zmaksymalizowali specyfikacje w prawie każdym wymiarze, aby zapewnić klientom wysoce wydajną platformę szkoleniową uczenia maszynowego z niskim kosztem wejścia i do 40% lepszą wydajnością cenową niż obecne oparte na GPU instancje EC2.

Gaudi w środku

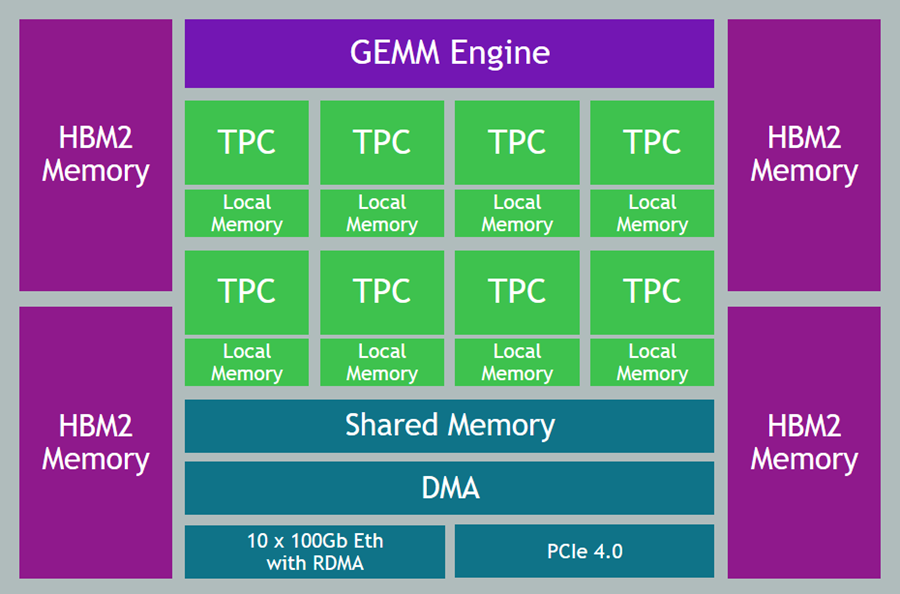

Akceleratory Gaudi są specjalnie zaprojektowane do treningu uczenia maszynowego i mają mnóstwo fajnych i interesujących funkcji i atrybutów:

- Typy danych – obsługa danych zmiennoprzecinkowych (BF16 i FP32), liczb całkowitych ze znakiem (INT8, INT16 i INT32) oraz liczb całkowitych bez znaku (UINT8, UINT16 i UINT32).

- Generalized Matrix Multiplier Engine (GEMM) – specjalistyczny sprzęt do przyspieszania mnożenia macierzy.

- Tensor Processing Cores (TPC) – wyspecjalizowane jednostki przetwarzające VLIW SIMD (Very Long Instruction Word / Single Instruction Multiple Data) przeznaczone do szkolenia ML. TPC są programowalne w języku C, chociaż większość użytkowników będzie korzystać z narzędzi i struktur wyższego poziomu.

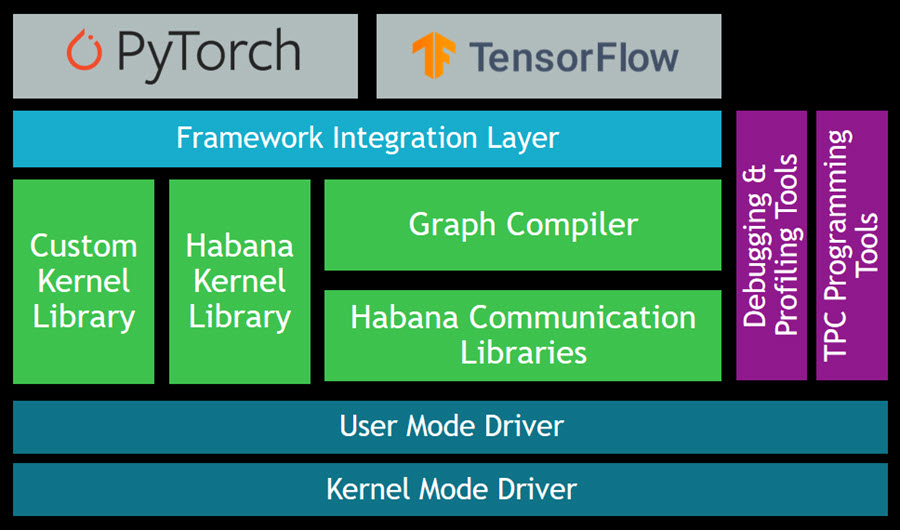

Pakiet Gaudi SynapseAI Software Suite for Training pomoże Ci budować nowe modele i migrować istniejące modele z popularnych frameworków, takich jak PyTorch i TensorFlow:

Poniżej znajdują się źródła, od których możesz zacząć:

- Podręcznik użytkownika TensorFlow – dowiedz się, jak uruchomić swoje modele TensorFlow w Gaudi.

- Podręcznik użytkownika PyTorch – dowiedz się, jak uruchomić modele PyTorch w Gaudi.

- Przewodnik po migracji modeli Gaudi – dowiedz się, jak przenieść PyTorch lub TensorFlow do Gaudi.

- HabanaAI Repo – to duże, aktywne repozytorium zawiera instrukcje konfiguracji, modele referencyjne, artykuły akademickie i wiele więcej.

Możesz użyć narzędzi programowania TPC, aby pisać, symulować i debugować kod, który działa bezpośrednio na TPC, a także możesz użyć biblioteki komunikacyjnej Habana (HCL) do tworzenia aplikacji, które wykorzystują moc wielu akceleratorów. Biblioteka Habana Collective Communications Library (HCCL) działa na szczycie HCL i zapewnia dostęp do zbiorowych zasobów dla operacji redukcji, rozgłaszania, zbierania i rozpraszania.

Dostępne od teraz

Instancje DL1 są obecnie dostępne w regionach wschodnich stanów (Wirginia Północna.) oraz zachodnich stanów USA (Oregon) w formie na żądanie i Spot. Możesz także kupić Instancje Zarezerwowane i Plany Oszczędnościowe.

źródło: AWS